1、问题描述测试cephfs内核客户端的吞吐性能cephfs内核客户端,direct写时单个客户端性能有上限cephfs内核客户端,只能接近150 mbs查看网卡流量,并没有打满查。

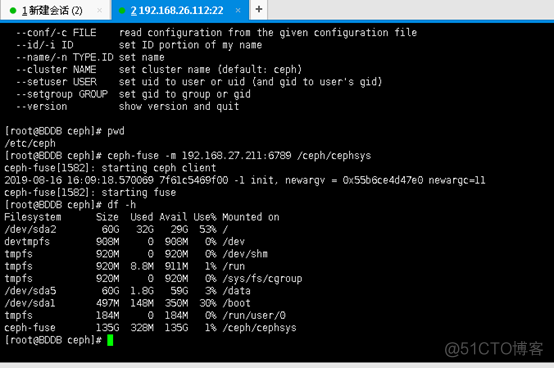

2、CephFS 后端和 EOS 前端服务的性能后端直接在客户端内核挂载上使用dd命令,以研究 CephFS 后端的流式传输性能前端通过。

3、这里是重点,因为cephfs客户端在内核是单线程的,如果只有一个挂载点,不能并发的读写,所以我们要在一台服务器上创建30个。

4、方式1将CephFS以内核或FUSE方式挂载到NAS服务器,然后通过samba以本地目录的方式导出方式2通过samba的 vfs object。

5、ceph集群cephfs使用详解#一个完整的ceph集群,可以提供块存储文件系统和对象存储本节主要介绍文件系统cephfs功能如何灵活。

6、操作系统,客户端由于 CephFS 内核模块要求,使用 42 内核6Ceph 为 Jewel 版本测试内容 1 Fuse VS Kernel Kernel 完胜2 单目录。

7、稳定性还是不错的建议如果用kernel client模式,升级内核到4x以上,否则推荐使用fuse模式Q9 cephfs对文件数量有限制么?A。

8、CephFS 使用测试报告Ebay 是 OpenStakck 的重度使用者,Ebay 私有云团队负责整个 Ebay 的私有云建设,包括多个跨数据中心的。

9、2019年7月18日 一些地方随后讲解了使用 cephdeploy怎么去部署一个多节点的Ceph集群架构,最后又详细的介绍了Ceph的块存储,对象存储,文件存储的实现方式和通过客户。

标签: cephfs内核客户端